Comment Nvidia transforme une simple image en rendu 3D animé grâce à l’IA (2) - Android

Nvidia Research a dévoilé GANVerse3D, une nouvelle technologie boostée par l'IA qui peut transformer une simple photo en modélisation 3D animée et personnalisable.

GANVerse3D a permis la modélisation de Kitt de la série K2000 // Source : Nvidia

Une fois encore, l’intelligence artificielle développée par Nvidia étale ses prouesses technologiques. Formée grâce au GAN (Generative Adversarial Network) qui l’entraîne à coup de passage en revue de centaines de milliers d’images, et à l’ADA (Adaptative Discriminator Augmentation) qui permet de transformer les images de manière adaptative et sélective pour les peaufiner, l’IA peut ainsi compenser l’absence d’une bibliothèque suffisamment importante pour s’enrichir d’informations qu’il faut ensuite mouliner.

Et la dernière exploitation des possibilités de cette IA est assez impressionnante.

Gonfler la photo pour en faire un modèle 3D

Nvidia Research a mis au point un nouveau moteur de deep learning qui va permettre de créer des modélisations 3D d’objets à partir de simples images en 2D. Tout cela passe par une nouvelle application baptisée GANVerse3D et élaborée par le Nvidia AI Research Lab de Toronto.

Alimentée par des milliers d’images ingurgitées au préalable, GANVerse3D va pouvoir « gonfler l’image » pour lui donner vie en 3D et même l’animer sur un ordinateur dans un environnement virtuel.

GANVerse 3D permet de donner vie à une modélisation 3D à partir d’une photo (à droite) // Source : Nvidia

Nvidia espère séduire les architectes, créateurs de jeu vidéo, concepteurs, ou encore les storyboarders de cinéma, en proposant un outil facile d’usage, « même pour ceux qui n’ont jamais modélisé en 3D », pour ajouter des éléments à un rendu, une maquette, une ébauche…

Pour prouver la force de son moteur, Nvidia a modélisé KITT, la célèbre voiture de la série K2000. À partir d’une simple photo, la voiture noire au bandeau LED rouge s’est retrouvée virtualisée sur un ordinateur en 3D, roulant dans une scène virtuelle, avec les feux allumés ou clignotants et des effets de lumière sur la carrosserie.

Le kit Nvidia Omniverse et les outils Nvidia PhysX ont ensuite prédit une texture avec des matériaux de haute qualité qui pourraient être ceux de KITT pour lui donner un peu plus de réalisme. GANVerse3D se présente ainsi comme une extension d’Omniverse « pour aider les artistes à créer des mondes virtuels plus riches pour développer des jeux, faire de la planification urbaine ou concevoir de nouveaux modèles d’apprentissage », ajoute Jean-François Lafleche, spécialiste du deep learning chez Nvidia.

La firme américaine a ensuite montré combien il était aisé de changer la couleur, la texture et n’importe quel élément du véhicule tout en le faisant évoluer dans son décor.

Faisable avec des objets ou des chevaux, pas encore des personnes

Pour parvenir à cela, il a fallu nourrir GANVerse3D de plus de 55 000 images de véhicules en tous genres, des « images réelles », insiste Juan Gao, chercheur et auteur du projet. Des photos prises avec des angles différents ont ainsi été intégrées, puis synthétisées grâce à la technologie GAN de Nvidia. Et le processus s’est mis en marche pour mailler les photos 2D et donner un rendu 3D. Il suffit ensuite d’injecter une seule photo d’un modèle pour que le logiciel fasse son travail et obtenir un rendu rapidement.

Lien YouTube

Épaulés par un moteur de rendu neuronal 3D, des développeurs peuvent ensuite contrôler la personnalisation de l’objet, changer l’arrière-plan. Exécuté avec un GPU Nvidia RTX et la plateforme Nvidia Omiverse, récemment annoncée et conçue pour les entreprises qui veulent collaborer en temps réel en 3D, GANVerse3D sera en mesure de recréer le modèle 3D en moins d’une seconde. Le rendu n’est pas aussi précis et peaufiné que l’original, mais le but n’est pas là. Il s’agit d’obtenir un résultat rapidement, à moindres frais, et facile d’utilisation.

La force des chercheurs de Nvidia est d’avoir réussi à améliorer leur modèle GAN, alimenté par des milliers de photos, pour que son IA puisse générer des données afin de créer un objet en 3D à partir d’une simple photo 2D. Pour accélérer le processus et générer rapidement les données, la technologie choisit de proposer un rendu avec une perspective du véhicule à une certaine hauteur et à une distance de caméra définie.

Pour le moment, GANVerse3D fonctionne parfaitement avec des véhicules, des chevaux, des bâtiments, des objets géométriques fixes et même des visages humains. Pour le corps entier, Nvidia explique ne pas avoir assez d’éléments au niveau des mouvements possibles pour pouvoir obtenir un résultat satisfaisant. Mais ce n’est qu’une question de temps.

16/04/2021 04:00 AM

Samsung passerait directement du Galaxy Z Flip au Z Flip 3

16/04/2021 11:15 AM

Quels sont les meilleurs drones en 2021

16/04/2021 10:30 AM

OneUI - 11 astuces pour maîtriser votre smartphone Samsung

16/04/2021 03:13 PM

Le prix du Samsung Galaxy Z Flip est en chute libre sur Amazon (-47 percent)

16/04/2021 02:37 PM

Comment Nvidia transforme une simple image en rendu 3D animé grâce à l’IA

16/04/2021 01:00 PM

Quels sont les meilleurs smartphones 5G en 2021

16/04/2021 04:50 PM

- Racing

- Sports Games

- Comics

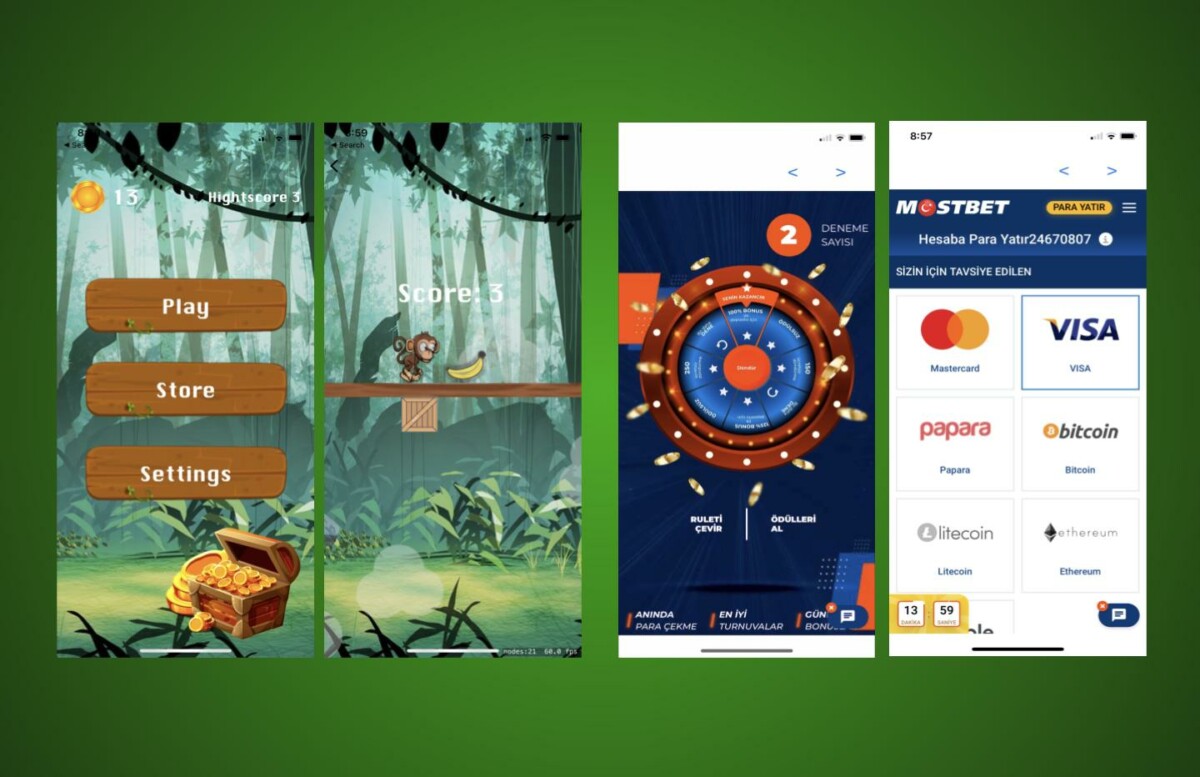

- Cards & Casino

- Media & Video

- HEALTH

- Libraries & Demo

- Arcade & Action

- Photography

- Transportation

- Weather

- Social

- Casual

- Brain & Puzzle

- Productivity

- Communication

- Finance

- Medical

- Health & Fitness

- Personalization

- Shopping

- Tools

- Sports

- Entertainment

- Business

- Music & Audio

- News & Magazines

- Books & Reference

- Education

- Lifestyle

- Travel & Local